在数智化转型浪潮中,实时分析、降本增效的需求以及AI技术的发展正推动现代数据分析快速变革。

(上图为张友东在StarRocks Connect 2025演讲)

在日前举办的StarRocks Connect 2025上,镜舟科技CTO&StarRocks TSC member张友东,介绍了Agentic AI时代,现代数据分析面临的挑战和机遇,以及StarsRocks在Lakehouse、AI Agent方面的思考与实践,他强调,StarsRocks要打造更具性价比的实时分析方案。

Lakehous带来数据分析架构变革

随着数智化转型深入,数据驱动的战略已经成为刚需。数据分析也从传统的BI向运营分析(Operational Analytics)转变,从服务于管理者的年度、季度、月度报表,到服务于全员的数据洞察,更多的企业把数据分析深入到日常经营,以实时的数据洞察,指导业务经营决策。

张友东指出,当前AI的发展也对数据也提出了新的要求,第一,数据要新鲜,模型需要最新的信息才能做出准确判断;第二,访问要快,AI Agent不能等几分钟才拿到数据;第三,数据处理要高效,为模型训练准备高质量数据。

现代数据分析已经走入了新的发展阶段,面临数据新鲜度、查询延时、查询并发等多方面的挑战,传统的Hadoop+MPP架构,逐渐被云原生数仓、Lakehouse(湖仓一体)和实时分析型数据库等更简洁、高效的架构替代。

近年来,Lakehous已经成为数据分析架构非常明确的发展趋势,被认为是下一代数据分析架构,国外包括AWS、微软、谷歌等云厂商,以及Snowflake、Databricks两大数据厂商都在争相布局Lakehouse,国内以镜舟科技(StarRocks的商业版提供商)为代表的数据厂商也在积极投身Lakehouse,成为Lakehouse的布道者和实践者。

传统数据仓库是结构化数据的首选架构,拥有高性能和高可靠性的优势。相比之下,数据湖(Data Lake)旨在处理大量非结构化和半结构化数据,具有灵活性和可扩展性,但往往以牺牲性能和数据一致性为代价。Lakehouse(湖仓一体)旨在将数仓和数据湖的能力融合到统一的平台中,通过使用开放数据格式,支持ACID事务,并提供强大的分析功能,Lakehouse使企业能够在不牺牲速度或可靠性的情况下将所有类型的数据进行统一存储,并提供高效的数据分析。

Lakehouse能够成为热门的数据技术概念,并逐渐被更多客户所接受,从本质上讲,它是一种新的数据管理范式,结合了数据仓库和数据湖的功能和优势,这种新的架构代表了处理数据的方式的重大根本转变。

虽然越来越多的客户认可了Lakehouse的价值,但是现实情况较为复杂,张友东在与用户交流过程中发现,大家对Lakehouse并没有形成统一的认知,有的用户觉得Hadoop就是 Lakehouse,因为它是存算分离架构,Hive就可以作为open Lake。另外还有一些用户认为用了OSS S3等对象存储作为Lake,上面做分析,也是Lakehouse。

张友东指出,现在全球方面对Lakehouse逐渐形成共识,更多是基于新一代的表格式来构建,能够支持增删改查,支持事务,支持一系列以前数据仓库的能力,以此来作为基本底座。整体来看,Lakehouse数据分析架构由存储、Catalog和计算引擎三大核心元素组成:

存储:Lakehouse 通常以低成本的对象存储作为数据底层,数据以开放格式存储。目前流行的表格式包括Iceberg、Hudi、Delta Lake和Paimon。其中Iceberg因其开放性、Paimon因其实时的理念,在业界备受关注。

Catalog:湖上的数据统一以元数据目录Catalog的方式呈现,这样便于数据的统一管理,方便数据的访问、共享与治理,当前流行的Catalog包括HMS、AWS Glue Catalog、Snowflake开源的Polaris Catalog、Databricks开源的Unity Catalog。从当前趋势看,业界正在逐步往REST Catalog方向演进。

计算引擎:计算引擎直接基于湖上的数据完成计算任务,服务BI、AI等不同应用场景。

StarRocks打造更具性价比的实时分析方案

前面已经提到,实时分析已经成为企业的刚需,实时数仓、Lakehouse等新技术成为企业构建现代数据分析架构的新选择。

实时分析场景主要包含实时数仓和实时湖仓两大场景,“StarRocks的理念是为客户提供更具性价比的实时分析方案。”

在实时数仓场景,2023年推出的StarRocks 3.0版本从存算一体架构升级为更具性价比的存算分离架构,可以使用低成本的对象存储,计算按需弹性,并通过Multi-warehouse虚拟多仓库实现业务隔离,在即将发布的StarRocks 4.0版本会持续强化性能和稳定性。

StarRocks通过创新的架构设计和优化策略,在存算分离环境中实现了低成本、高性能的实时分析能力:通过全链路CDC数据同步集成、高并发合并小事务写入优化、文件合并降低API调用次数等策略,实现实时写入和低成本存储;采用分布式MPP架构,通过智能CBO优化、Query Cache、丰富的索引、全链路向量化执行、透明物化视图、多表join、FlatJSON支持打造高性能查询引擎;此外,通过快速故障转移机制和多计算副本保障业务连续性。

在实时数仓场景,北美社交平台Pinterest,拥有5亿月活用户,其实时分析广告平台数据新鲜度要求10s,查询小于1s。此前使用的Apache Druid缺乏连接和更新支持,数据采集管道存在外部依赖,存在可扩展性与高成本问题,面临实时分析挑战。升级到StarRocks后,通过实时更新和多表join功能可以更好地支持新场景,同时,采用原生采集简化管道(Pipeline),可以直接用StarRocks进行实时分析,相比Apache Druid,P90延迟降低50%,整体的计算和存储成本降低68%。

在Lakehouse实践中,相比于数据仓库,数据湖需要远端获取元数据,IO链路长,数据湖上的数据比较松散,能否在数据湖上实现媲美数据仓库的查询性能,是一个核心挑战。当下很多计算引擎会出现数据湖查询性能低的问题,不得不将数据从数据湖导入到专有实时数仓中,这样会产生数据“烟囱式”的架构,导致数据栈复杂、数据分散,带来较高的系统建设成本和运维成本。

张友东介绍,StarRocks湖上查询通常分为以下几个阶段:获取数据湖元数据、构建执行计划、读取数据,并完成整个执行Pipeline。每个阶段StarRocks都开发了相关的技术来让湖上查询变得更加高效,包括元数据缓存、湖上自动统计信息CBO优化、I/O 合并、Data Cache、向量化执行等。同时StarRocks还支持在数据湖上创建物化视图,利用StarRocks细粒度分区分桶、丰富的索引能力进一步加速查询。

过去几年,StarRocks在持续优化数据湖上的数据分析性能,通过上述技术创新,StarRocks 在数据湖上的查询分析性能已经接近Native table的分析性能。

此外,为了降低数据湖构建门槛,StarRocks也持续在数据集成和数据治理方面不断强化,“做到让用户使用Iceberg table像使用StarRocks native table一样,把数据导入进去就不用管了,可以直接服务线上业务。”张友东说。

StarRocks凭借存算分离架构和工程创新实践,打造数据仓库/数据湖、离线分析/在线实时分析的统一数据分析引擎,不仅能够简化技术栈,降低运维复杂度,同时避免了数据“烟囱”问题,为业务提供秒级的数据新鲜度,以及亚秒级的查询能力。

在实时湖仓场景,北美线上体育平台Fanatics的数据全部统一存储在基于Iceberg的数据湖里,而在分析场景将数据从湖导入到各专用数仓中,跨多个仓库的分片数据集产生了数据孤岛,很难做关联分析,同时专用的系统也导致了高昂的计算和存储成本,无法支持实时用例。通过构建StarRocks Lakehouse实时湖仓方案,提供统一批处理与实时分析,服务上层BI、AI应用场景。这种实时湖仓方案,无需额外仓库成本,可以节省90%开支。

在现代数据分析变革中乘风破浪

StarRocks作为一个开源的高性能分析型数据库,经过五年快速发展,已在全球范围内获得广泛认可。技术发展方面,从1.0版本以高性能吸引首批用户,到2.0版本强化实时分析能力,再到3.0版本实现存算分离架构和Lakehouse能力提升,即将推出的4.0版本将在AI Agent方面有更多突破。开源发展方面,2023年捐赠给Linux基金会,目前开源GitHub Stars已经突破11000。商业发展方面,目前已被全球500+家估值超10亿美元的企业采用,包括中国众多行业头部企业,以及Shopee、Grab、Intuit、Verizon、Coinbase、Pinterest、Celonis等国际知名公司,业务遍及亚洲、北美、欧洲等地区,正逐步成为全球数据分析领域的主流选择。

在实时分析和降本增效的需求推动下,越来越多的国内外企业选择StarRocks,其中既有替换原有系统,也有新增业务场景。

张友东介绍,大部分企业往往是在现有技术栈(如Hadoop或传统数仓)中遇到了一个无法解决的“痛点”,最典型的是实时分析场景,很多企业通过Hadoop建设了多个数据中台,用Impala和Hive这样的引擎进行数据分析,会有较高的延时,无法进行实时分析,这时候就会引入StarRocks,专门解决当下最棘手的问题。

一旦StarRocks在这个关键场景上证明了其远超旧系统的性能和效率,便能和企业建立起信任。客户发现,“原来数据分析可以这么快”。于是,他们会自发地将StarRocks的能力扩展到更多领域,比如用它来加速数据湖查询,甚至统一实时和离线的分析引擎。

除了上面提到的基于Iceberg的实时湖仓场景,也有企业基于StarRocks构建Streaming Lakehouse方案,比如最近火热的淘宝闪购,每天的交易高峰期上亿订单,产生了海量交易日志,面临高并发访问挑战,传统离线数仓数据新鲜度无法满足需求,而实时数仓则会带来较高的存储和计算成本。

淘宝闪购通过Flink+Paimon+StarRocks构建Streaming Lakehouse方案,数据通过Flink进行实时处理,写入到Apache Paimon数据湖中,然后通过StarRocks进行实时分析,可以实现1-5分钟的数据新鲜度,同时支持上百级别的高并发复杂分析。整个链路相比实时数仓也大幅降低了成本,Flink计算成本降低50%,改为对象存储后的存储成本降低90%。

当前的Agentic AI时代,现代数据分析也面临新的挑战和机遇。在会上,张友东也分享了StarRocks在AI方面的思考与实践。

当前,AI Agent可以可以针对性解决StarRocks用户在数据建模(如分区、分桶、排序等)等专业领域的高门槛问题,通过智能化辅助做好数据建模,可以让数据分析事半功倍。但是,单一大模型直接处理数据分析需求时,存在准确率低、易产生“幻觉”的问题。同时,AI Agent的高效运行对数据系统的接口兼容性、实时性、性能及数据质量提出了多重严苛要求。

StarRocks借鉴专家分析问题的拆解逻辑,采用Multi-Agent协作模式替代单一交互,将复杂任务拆解为独立模块逐一攻克,结合数据系统的原生能力构建可靠的AI Agent支撑体系。围绕AI Agent运行的核心需求,需要数据分析系统提供以下四方面支撑:

接口层适配:通过MCP Server暴露接口,或构建语义层、Text-to-SQL技术栈,提供自然语言交互能力,满足Agent的接入需求。

实时性保障:同步维护系统实时运行状态与最新文档,为Agent提供动态更新的上下文环境,确保分析决策贴合当前系统实际。

性能层支撑:依托自身低查询延时、高并发处理的原生优势,满足多Agent多轮交互的效率需求,保障协作链路顺畅运行。

数据质量管控:通过完善的数据治理体系提升底层数据质量,从根源上保障Agent分析结果的可靠性。

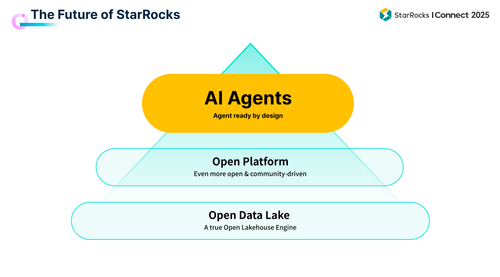

(图片来自StarRocks)

张友东指出,当前AI还在初步探索阶段,未来的Agentic AI时代,所有的系统都需要通过AI Agent交互,如何将底层的Lakehouse能力与AI Agent很好地结合起来非常关键,也充满挑战,StarRocks将通过打造“开源、开放”的平台,构建AI Agent—Ready的系统,在现代数据分析变革中乘风破浪。